「AIとチャットしていると、まるで人間と話しているみたい……」

ChatGPTなどの生成AIを使っていると、その自然な受け答えに驚かされることがありますよね。でも、ふと疑問に思うことはありませんか?

「AIは本当に言葉の意味を理解して話しているの?」

結論から言うと、

現在のAIは言葉の意味を人間のように「理解」しているわけではありません。

彼らの正体は、膨大なデータ計算によって

「次に来る言葉を確率的に予測しているだけのマシン」なのです。

この記事では、AIチャットボットの中身がどうなっているのか、なぜ「もっともらしい嘘」をつくのか、その仕組みを分かりやすく解説します。

目次

AIの正体は「超高性能な予測変換」

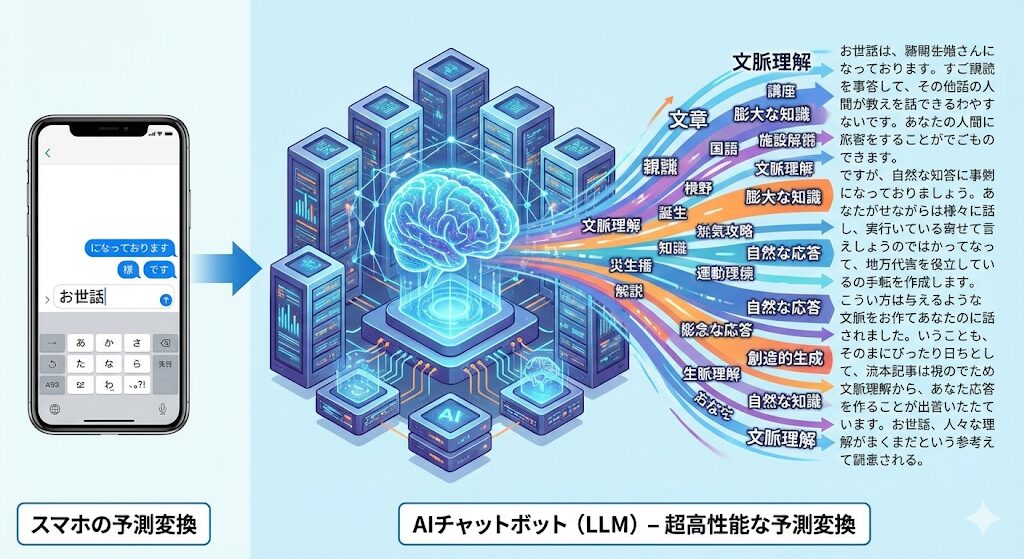

私たちが普段使っているAIチャットボット(LLM:大規模言語モデル)の仕組みを一言で表すと、「スマホの予測変換の超すごい版」と言えます。

「意味」ではなく「確率」で言葉を選んでいる

スマホで「お世話」と入力すると、次に「になっております」と予測変換が出ますよね。

これは、過去のデータから「『お世話』の後には『になっております』が続く確率が高い」と学習しているからです。

AIもこれと同じことを、桁違いの規模で行っています。

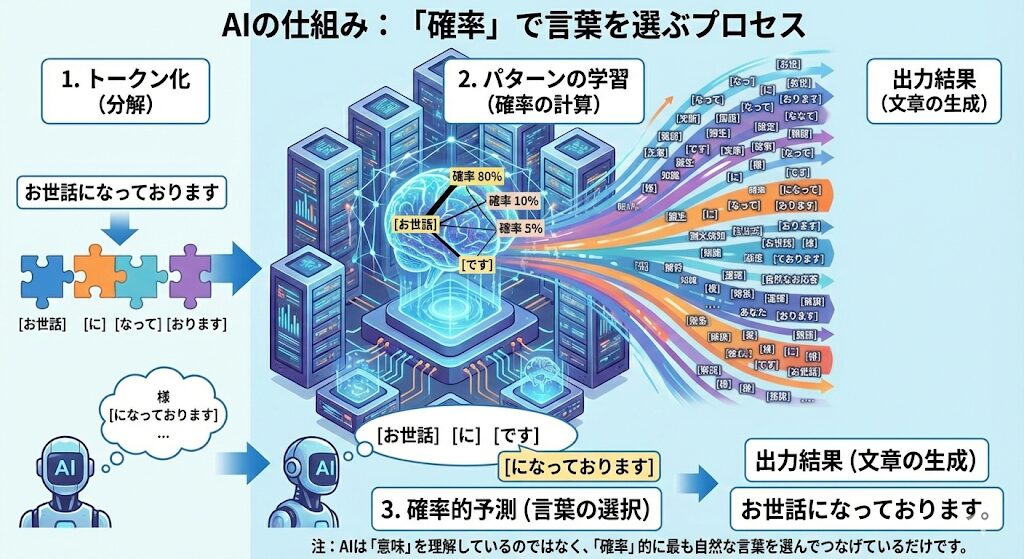

- トークン化:AIは文章を単語や文字の単位(トークン)に分解して処理します。

- パターンの学習:インターネット上の膨大な文章を読み込み、「この言葉の次には、どんな言葉が来るのが自然か」というパターンや関係性を学習しています。

- 確率的予測:質問に対して、最も確率が高い(=もっともらしい)言葉を次々とつなげて回答を生成しています。

つまり、AIは「悲しい」という言葉を使っても、悲しいという感情や意味を理解しているわけではなく、「ここでは『悲しい』という言葉を使うのが確率的に正解だ」と計算しているに過ぎないのです。

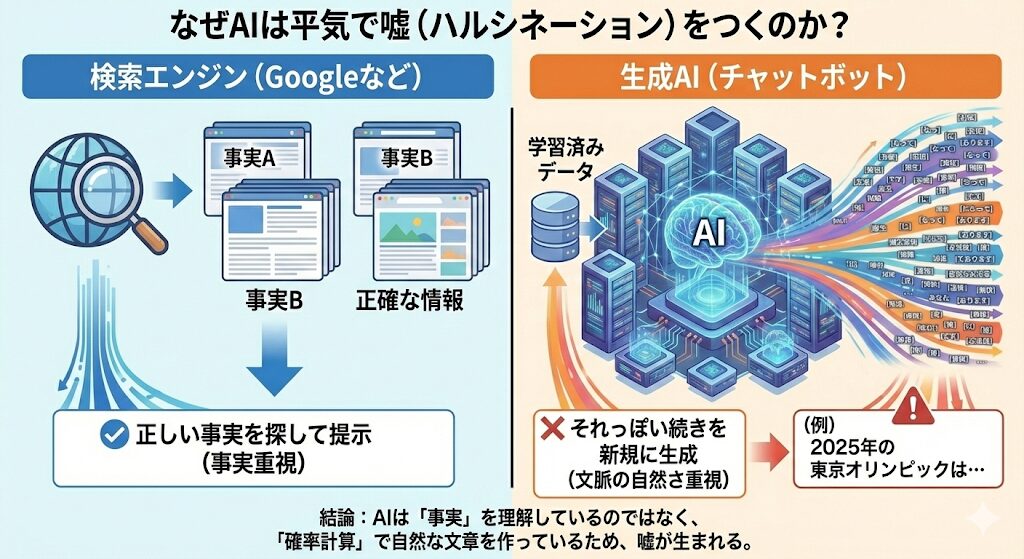

なぜ平気で嘘をつくの?(ハルシネーション)

AIを使っていると、事実とは全く異なることを自信満々に答えることがあります。

これを専門用語で「ハルシネーション(AI幻覚)」と呼びます。

なぜこんなことが起きるのでしょうか?

それは、AIが「検索エンジンではない」からです。

「事実」ではなく「それっぽい続き」を作っている

検索エンジン(Googleなど)は、Web上にある正しい情報を「探して」きます。

一方、生成AIは学習したデータをもとに、新しい文章を「作って(生成して)」います。

AIにとって重要なのは「文章として自然につながっているか」どうかです。

事実かどうかは二の次であるため、確率計算の結果として「嘘だけど、文脈としては自然な文章」が出来上がってしまうのです。

これが、もっともらしい嘘が生まれる原因です。

2026年1月現在、ハルシネーションはほとんど起きなくなってきましたが、油断は禁物。事実確認はしっかりしていきましょう。

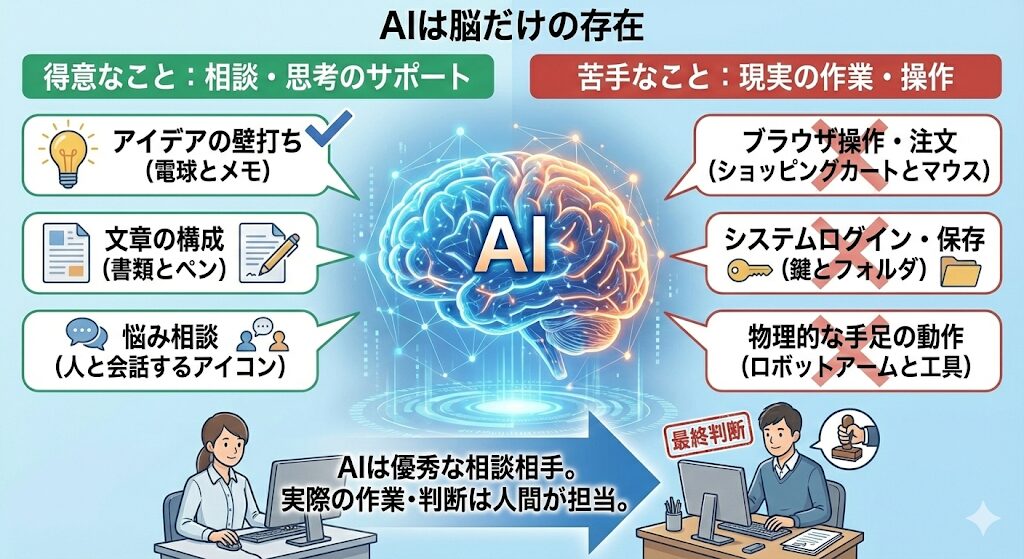

AIは「脳だけの存在」である

もう一つ、AIをうまく使いこなすために理解しておきたいのが、従来のAIチャットボットは「手足を持たない、脳だけの存在」だという点です。

「相談」は得意でも「作業」はできない

AIは膨大な知識を持っているので、以下のようなことは得意です。

- アイデアの壁打ち相手になる

- 文章の構成を考える

- 悩みごとの相談に乗る

しかし、基本的にはブラウザを操作して商品を注文したり、社内のシステムにログインしてファイルを保存したりといった「現実の作業(手足を動かすこと)」はできません(※現在はAIエージェントという決済まで行う外部機能も出来上がってきましたがそれはまた別のところで共有します。)。

そのため、AIはあくまで優秀な「相談相手」として活用し、実際の「作業」や「最終的な判断」は人間が行う必要があるのです。

まとめ

AIチャットボットの正体について解説しました。

- AIは意味を理解しているわけではなく、「次に来る言葉」を確率で予測しているだけ。

- 事実を探しているのではなく文章を作っているため、「もっともらしい嘘(ハルシネーション)」をつくことがある。

- 知識はあるが手足はない「脳だけの存在」なので、作業は人間がやる必要がある。

「AIは完璧な答えを知っている魔法の箱」ではなく、「言葉をつなげるのがめちゃくちゃ上手な計算機」だと割り切ることで、嘘に惑わされず、賢く付き合っていくことができるはずです。