「AIに聞けば正しい答えが返ってくる」「AIは人間よりも賢いから任せておけば安心だ」

もし現場でこのような「性善説」に基づいて生成AIを導入しているとしたら、それは非常に危険な状態です。

AIは悪気なく嘘をつき、もっともらしい顔をして誤った情報を提示することがあります。

ビジネスの現場でAIを安全かつ有効に活用するためのキーワードは、あえて「性悪説」で管理することです。

これはAIを敵視するということではなく、「AIは間違いを犯す可能性がある」という前提に立ち、必ず人間がチェックを行うプロセスを組み込むことを意味します。

本記事では、なぜAI導入において「性悪説」が必要なのか、そして具体的にどのように出力を疑い、管理すべきなのかを解説します。

目次

なぜAIに「性悪説」が必要なのか

生成AIは、膨大なデータを学習し、確率的に「次に来る言葉」をつなぎ合わせているに過ぎません。

そこに「真実を語ろう」という意思や、「嘘をついてはいけない」という倫理観は存在しません。

悪気なく嘘をつく「ハルシネーション」

生成AIが事実とは異なる情報を、さも事実であるかのように生成する現象を「ハルシネーション(幻覚)」と呼びます。

- 架空の判例や論文を捏造する

- 実在しない人物の経歴をもっともらしく語る

- 計算結果を間違える

これらはAIのバグではなく、仕組み上起こり得る仕様です。

総務省の『情報通信白書』や経済産業省の『AI事業者ガイドライン』でも、このハルシネーションリスクへの注意喚起がなされています。

「AIは嘘をつくもの」という前提(性悪説)に立たなければ、このリスクを防ぐことはできません。

「性悪説」に基づく3つの管理鉄則

現場でトラブルを防ぐためには、以下の3つのポイントを徹底して管理する必要があります。

1. 入力を疑う(機密情報を渡さない)

まず、AIに入力する情報そのものを管理します。

「AIサービス側がデータを学習しない設定」になっていたとしても、入力ミスや設定漏れのリスクはゼロではありません。実は情報漏洩のほとんどがヒューマンエラーです。

鉄則:個人情報、顧客データ、未公開の社内機密は絶対に入力させない。

「AIは入力された情報を漏らすかもしれない」と疑ってかかる姿勢が重要です。

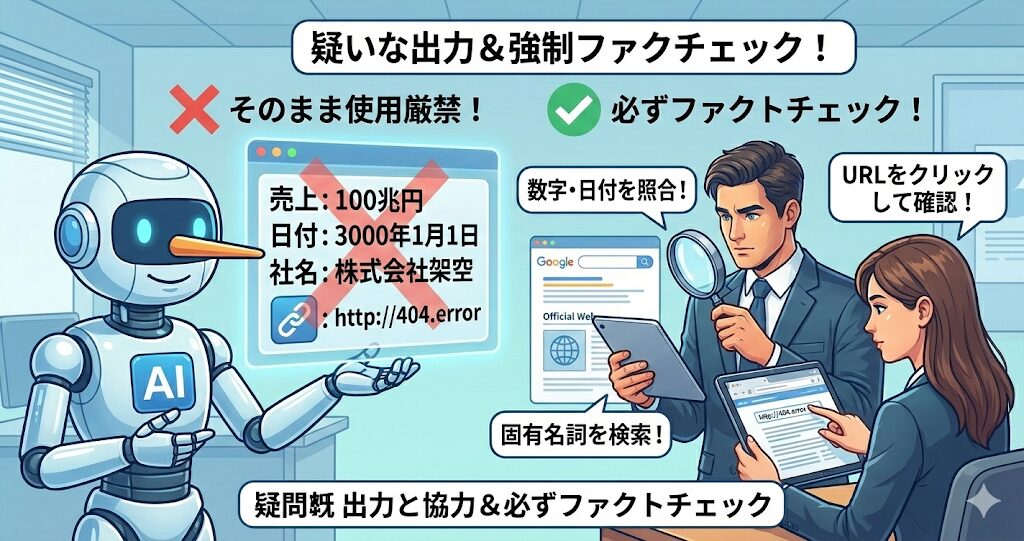

2. 出力を疑う(ファクトチェックの義務化)

AIが出力した回答をそのままメールや資料に貼り付けるのは厳禁です。

必ず「ファクトチェック(事実確認)」を業務プロセスに組み込んでください。

具体的には以下の確認を行います。

- 数字や日付:公式サイトや一次ソースと照合する

- 固有名詞:実在する人物や組織か検索して確認する

- URL:提示されたリンクが生きているか、正しいページかクリックして確認する

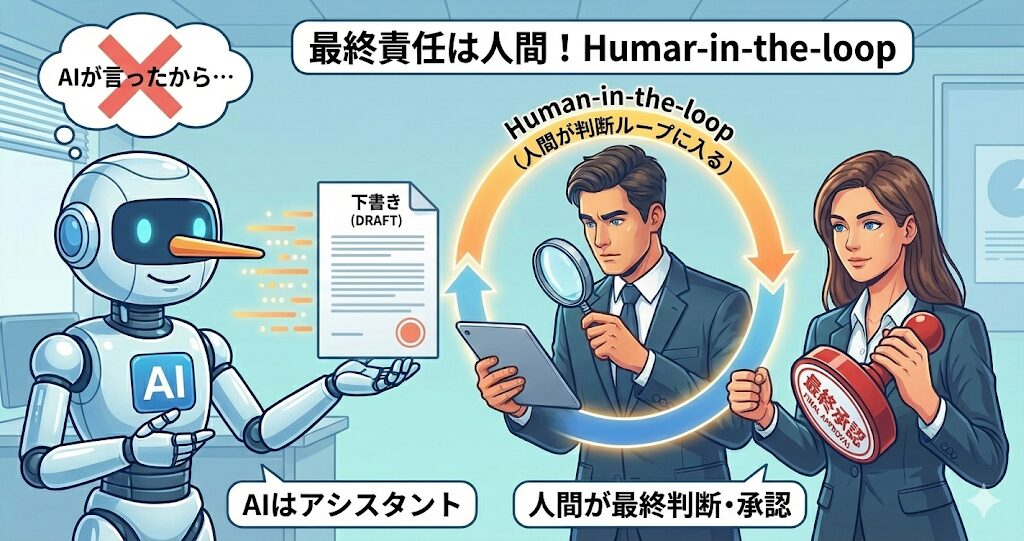

3. 責任の所在を疑う(Human-in-the-loop)

最終的な責任はAIではなく、それを使った人間にあります。

これを「Human-in-the-loop(人間が判断のループに入ること)」といいます。

「AIがこう言ったから」は言い訳になりません。

AIはあくまで「下書きを作成するアシスタント」であり、承認印を押すのは必ず人間の役割と定めておく必要があります。

具体的なファクトチェックの手順

では、現場では具体的にどのような手順でチェックを行えばよいのでしょうか。

誰でも実践できるシンプルなフローを紹介します。

| ステップ | アクション | ポイント |

|---|---|---|

| Step 1 | 出典の確認 | AIに「その情報の根拠(ソース)となるURLを教えて」と指示する。 |

| Step 2 | 一次情報の検索 | Google検索などでキーワード検索し、信頼できる公的機関や企業の公式サイトを探す。 |

| Step 3 | 突合確認 | AIの回答と、見つけた一次情報を見比べる。微妙なニュアンスの違いまで確認する。 |

特に専門的な分野や、トラブルに直結する契約関連の記述については、必ず専門家や担当部署によるダブルチェックを行うべきです。

まとめ

AIは非常に強力なツールですが、

それを使いこなすためには「無批判に信じる」のではなく、

「正しく疑う」リテラシーが求められます。

- AIは確率で言葉を紡ぐため、悪気なく嘘をつく

- 「性悪説」に立ち、入力・出力・責任の所在を厳格に管理する

- 必ず人間がファクトチェックを行い、最終判断を下す

「性悪説」で管理することは、AIの可能性を否定することではありません。

リスクをコントロールし、安心してAIの恩恵を享受するための賢い知恵なのです。